Quando você está tentando comunicar ou entender idéias, as palavras nem sempre fazem o truque. Às vezes, a abordagem mais eficiente é fazer um simples esboço desse conceito – por exemplo, diagramar um circuito pode ajudar a entender como o sistema funciona.

Mas e se a inteligência artificial pudesse nos ajudar a explorar essas visualizações? Embora esses sistemas sejam normalmente proficientes na criação de pinturas realistas e desenhos de desenhos animados, muitos modelos não conseguem capturar a essência de esboçar: seu golpe de golpe a golpe, o processo iterativo, que ajuda os seres humanos a discutir e editar como eles querem representar suas idéias.

Um novo sistema de desenho do Laboratório de Ciência da Computação e Ciência da MIT (CSAIL) e da Universidade de Stanford pode esboçar mais como nós. Seu método, chamado “SketchAgent”, usa um modelo de linguagem multimodal – sistemas de IA que treinam em texto e imagens, como o Claude 3,5 sonetos da Anthropic – para transformar os avisos de linguagem natural em esboços em alguns segundos. Por exemplo, ele pode desviar uma casa por conta própria ou por meio de colaboração, desenhando com um humano ou incorporando entrada baseada em texto para esboçar cada parte separadamente.

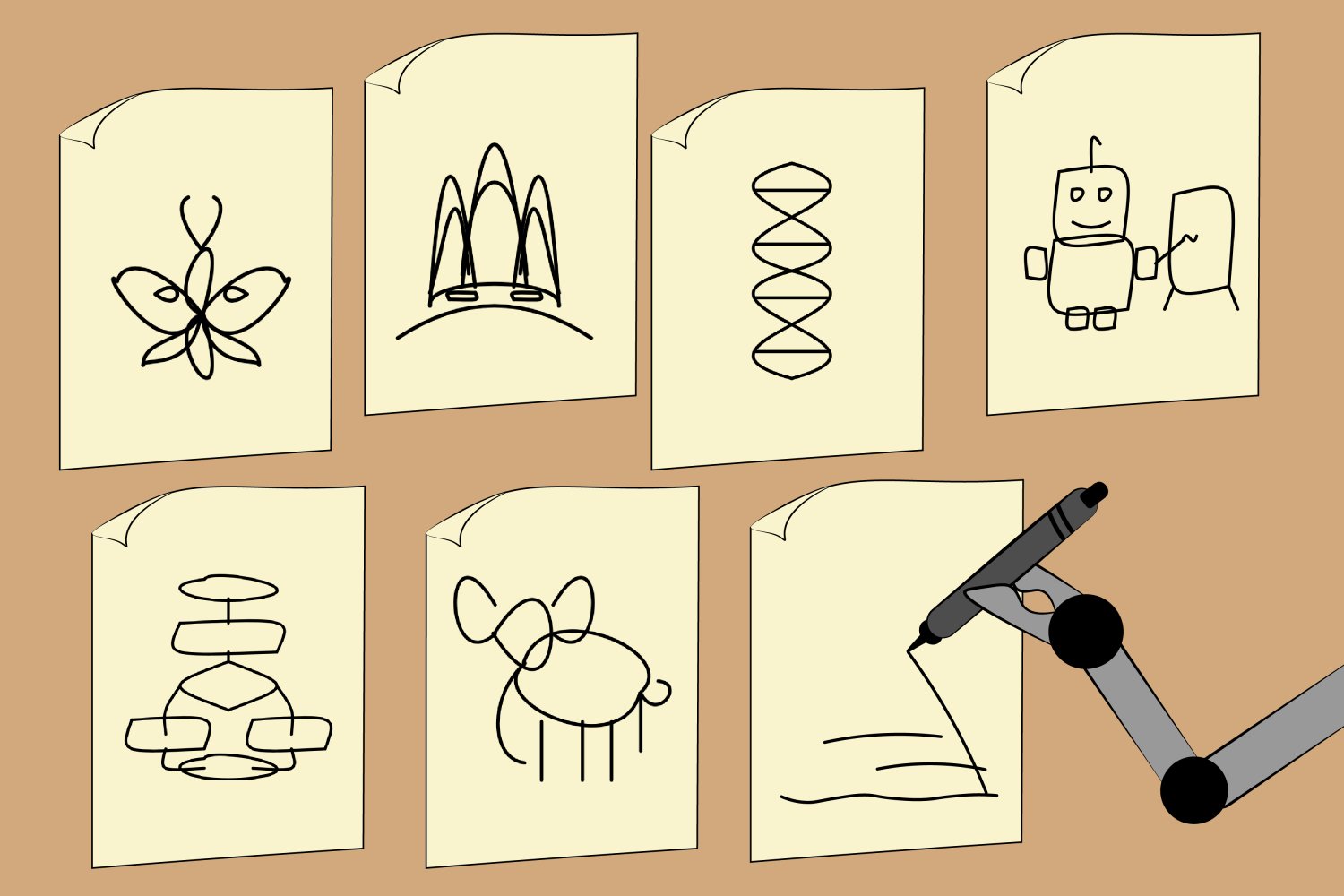

Os pesquisadores mostraram que o SketchAgent pode criar desenhos abstratos de diversos conceitos, como um robô, borboleta, hélice de DNA, fluxograma e até a Sydney Opera House. Um dia, a ferramenta pode ser expandida para um jogo de arte interativo que ajuda professores e pesquisadores a diagramar conceitos complexos ou dar aos usuários uma lição de desenho rápido.

Csail Postdoc Yael Vinker, que é o principal autor de um papel Apresentando o SketchAgent, observa que o sistema apresenta uma maneira mais natural para os humanos se comunicarem com a IA.

“Nem todo mundo está ciente de quanto eles desenham em sua vida diária. Podemos desenhar nossos pensamentos ou idéias de oficina com esboços”, diz ela. “Nossa ferramenta visa imitar esse processo, tornando os modelos de linguagem multimodal mais úteis para nos ajudar a expressar idéias visualmente.”

O SketchAgent ensina esses modelos a desenhar um golpe sem treinamento em nenhum dado-em vez disso, os pesquisadores desenvolveram uma “linguagem de desenho” na qual um esboço é traduzido em uma sequência numerada de traços em uma grade. O sistema recebeu um exemplo de como coisas como uma casa seriam desenhadas, com cada golpe rotulado de acordo com o que representava – como o sétimo golpe sendo um retângulo rotulado como uma “porta da frente” – para ajudar o modelo a generalizar para novos conceitos.

Vinker escreveu o artigo ao lado de três afiliadas da CSAIL – PostDoc Tamar Rott Shaham, pesquisador de graduação Alex Zhao e Professor Antonio Torralba – bem como Kristine Zheng e a assistente professora Judith Ellen Fan. Eles apresentarão seu trabalho na conferência de 2025 sobre visão computacional e reconhecimento de padrões (CVPR) este mês.

Avaliando as habilidades de desenho da IA

Embora os modelos de texto para imagem como o Dall-E 3 possam criar desenhos intrigantes, eles não têm um componente crucial do esboço: o processo criativo espontâneo, onde cada AVC pode impactar o design geral. Por outro lado, os desenhos do Sketchagent são modelados como uma sequência de golpes, parecendo mais naturais e fluidos, como esboços humanos.

Os trabalhos anteriores também imitaram esse processo, mas treinaram seus modelos em conjuntos de dados desenhados humanos, que geralmente são limitados em escala e diversidade. O SketchAgent usa modelos de linguagem pré-treinados, que têm conhecimento de muitos conceitos, mas não sabem como esboçar. Quando os pesquisadores ensinaram modelos de idiomas, esse processo, SketchAgent começou a esboçar diversos conceitos em que não havia treinado explicitamente.

Ainda assim, Vinker e seus colegas queriam ver se SketchAgent estava trabalhando ativamente com humanos no processo de desenho ou se estava trabalhando independentemente de seu parceiro de desenho. A equipe testou seu sistema no modo de colaboração, onde um modelo humano e um idioma trabalham para desenhar um conceito específico em conjunto. A remoção das contribuições de SketchAgent revelou que os golpes de sua ferramenta eram essenciais para o desenho final. Em um desenho de um veleiro, por exemplo, remover os golpes artificiais representando um mastro tornou o esboço geral irreconhecível.

Em outro experimento, os pesquisadores da CSAIL e da Stanford conectaram diferentes modelos de linguagem multimodal ao SketchAgent para ver o que poderia criar os esboços mais reconhecíveis. Seu modelo de backbone padrão, Claude 3,5 sonetos, gerou os gráficos vetoriais mais humanos (essencialmente arquivos baseados em texto que podem ser convertidos em imagens de alta resolução). Ele superou modelos como GPT-4O e Claude 3 Opus.

“O fato de Claude 3,5 sonetos ter superado outros modelos como GPT-4O e Claude 3 Opus sugere que esse modelo processa e gera informações relacionadas à visual de maneira diferente”, diz o co-autor Tamar Rott Shaham.

Ela acrescenta que o SketchAgent pode se tornar uma interface útil para colaborar com os modelos de IA além da comunicação padrão baseada em texto. “À medida que os modelos avançam na compreensão e geração de outras modalidades, como esboços, eles abrem novas maneiras para os usuários expressarem idéias e receberem respostas que parecem mais intuitivas e humanas”, diz Shaham. “Isso pode enriquecer significativamente as interações, tornando a IA mais acessível e versátil”.

Embora a proezas de desenho do SketchAgent seja promissora, ele ainda não pode fazer esboços profissionais. Ele torna representações simples de conceitos usando figuras e rabiscos, mas luta para rabiscar coisas como logotipos, frases, criaturas complexas como unicórnios e vacas e figuras humanas específicas.

Às vezes, seu modelo também entendeu mal as intenções dos usuários em desenhos colaborativos, como quando Sketchagent desenhou um coelho com duas cabeças. De acordo com Vinker, isso pode ser porque o modelo divide cada tarefa em etapas menores (também chamadas de raciocínio “Chain of Thought”). Ao trabalhar com os seres humanos, o modelo cria um plano de desenho, potencialmente interpretando mal qual parte desse delineamento um humano está contribuindo. Os pesquisadores poderiam refinar essas habilidades de desenho treinando dados sintéticos de modelos de difusão.

Além disso, o SketchAgent geralmente requer algumas rodadas de solicitação para gerar rabiscos humanos. No futuro, a equipe pretende facilitar a interação e o esboço com modelos de linguagem multimodal, incluindo refinar sua interface.

Ainda assim, a ferramenta sugere que a IA pode atrair diversos conceitos da maneira como os humanos fazem, com a colaboração de AI-AI, passo a passo, que resulta em projetos finais mais alinhados.

Este trabalho foi apoiado, em parte, pela National Science Foundation dos EUA, uma concessão de Hoffman-Yee do Instituto Stanford de IA centrada em humanos, da Hyundai Motor Co., do Laboratório de Pesquisa do Exército dos EUA, do Programa de Liderança STEM de Zuckerman e da Viterbi Fellowship.